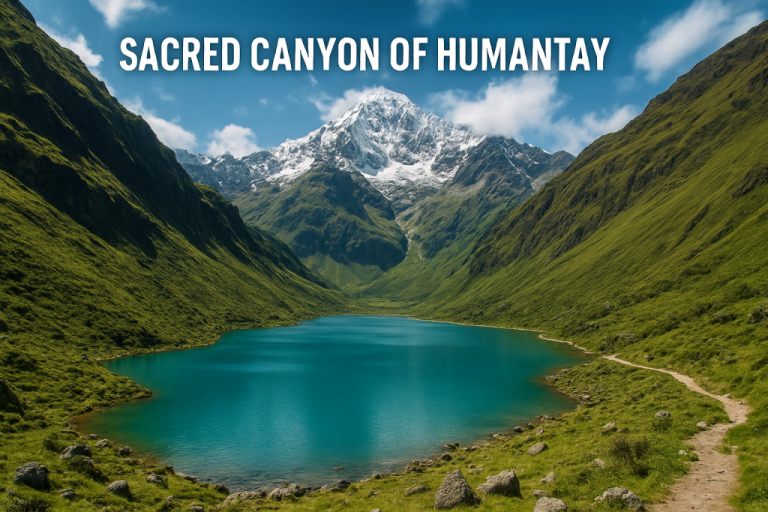

Lo que parecía una experiencia mística en la naturaleza terminó siendo un completo fiasco. Dos turistas extranjeros pagaron 160 dólares para conocer el supuesto “Cañón Sagrado de Humantay”, una atracción que según las imágenes y descripciones que encontraron en internet prometía paisajes impactantes y energía espiritual. Sin embargo, al llegar al punto indicado, se dieron cuenta de algo insólito: el lugar no existía.

El guía local Miguel Ángel Góngora Meza, quien los acompañó en la excursión, relató que los visitantes le mostraron capturas de pantalla con textos detallados y fotografías convincentes generadas por herramientas de inteligencia artificial. El itinerario parecía real, con coordenadas, reseñas y recomendaciones de otros supuestos viajeros. Pero al seguir la ruta, terminaron abandonados en una carretera rural, sin señal ni destino claro.

Este episodio ha despertado una discusión global sobre los riesgos de confiar ciegamente en contenidos creados por IA. Plataformas y modelos generativos combinan información, imágenes y lenguaje natural para producir escenarios que “parecen” auténticos, pero que muchas veces no tienen respaldo geográfico ni verificación humana.

Y aunque pueda sonar extremo, no es un caso aislado. En Chile, más de una vez se han viralizado “cabañas soñadas”, “hoteles ecológicos” o “viajes de estudio de ensueño” que resultan ser completamente falsos o inexistentes. Incluso algunas personas han caído en estafas digitales vinculadas a reservas creadas con material generado por IA.

El consejo es claro: antes de reservar o embarcarse en una experiencia fuera de lo común, verifica la información en fuentes oficiales o locales, revisa reseñas reales y desconfía de lo que parece “demasiado perfecto”.

Porque si algo nos enseña este caso es que, en tiempos de inteligencia artificial, no todo lo que ves en internet es real… ni siquiera el paisaje más hermoso.